Transformer 是神經網路嗎:深度解析其革命性本質與人工智慧浪潮的推手

你或許也曾有過這樣的疑惑,就像我剛接觸深度學習時,聽到同事興奮地談論著「Transformer如何如何強大,徹底改變了自然語言處理」,心裡不禁納悶:「咦?那這Transformer究竟是何方神聖?它到底是不是神經網路的一種呢?還是說它是一種全新的、截然不同的技術範疇?」這個問題,其實不單單是初學者會感到困惑,就連許多已經踏入人工智慧領域一陣子的朋友,有時候也會在概念上稍微打結,不確定該如何精確地定位它。

Table of Contents

Transformer 毋庸置疑是人工神經網路的一種

讓我開門見山、簡潔明瞭地給出答案:是的,Transformer 絕對是一種人工神經網路。更精確地說,它是一種最先進、也最為成功的深度學習模型架構,而深度學習正是人工神經網路領域中的一個重要分支。它承襲了神經網路學習資料模式、從數據中自動萃取特徵的核心思想,並透過巧妙的設計,克服了許多傳統神經網路在處理特定任務(尤其是序列資料)時的局限性,進而引領了當前人工智慧領域的蓬勃發展。

我的經驗告訴我,要真正理解Transformer為何如此重要,首先得回溯到神經網路的根本,接著再層層剝開Transformer的「洋蔥」,一窺它那令人驚豔的內部構造與運作機制。這不只是一場技術的探索,更是對人工智慧發展脈絡的一次深度思考。

何謂神經網路?先從基礎說起

在我們深入探討Transformer之前,讓我們先花點時間,釐清「神經網路」這個詞彙究竟代表什麼。畢竟,理解根基才能更好地欣賞上層建築的精妙。

人工神經網路(Artificial Neural Network, ANN),顧名思義,是一種受到生物神經網路啟發的計算模型。它並非真的模仿我們大腦裡的神經元那麼複雜,但其核心概念卻異曲同工:

-

節點與連接: 神經網路由一層層相互連接的「節點」(或稱「神經元」)組成。每個節點接收來自前一層節點的輸入,這些輸入會乘上一個對應的「權重」(Weights),並加上一個「偏差」(Bias)。

-

激活函數: 經過加權求和後,結果會通過一個非線性的「激活函數」(Activation Function)。這個激活函數的引入至關重要,它讓網路能夠學習並模擬複雜的非線性關係,而不是僅僅處理簡單的線性問題。常見的激活函數有ReLU、Sigmoid、Tanh等。

-

分層結構: 這些節點通常組織成輸入層、一個或多個隱藏層(Hidden Layers)和輸出層。層與層之間的全連接(或部分連接)構成了網路的拓撲結構。

-

學習機制: 神經網路透過「訓練」來學習。在訓練過程中,我們會將大量的輸入資料餵給網路,並提供對應的正確輸出(標籤)。網路會計算其預測結果與真實結果之間的「誤差」(Loss),然後透過「反向傳播」(Backpropagation)演算法,微調每個連接的權重和偏差,以期最小化這個誤差。這個過程會不斷迭代,直到網路的表現達到預期水準。

簡單來說,神經網路就是一種強大的模式識別與函數逼近器,能夠從海量的資料中自動學習規律和特徵,進而完成分類、預測、生成等任務。而「深度學習」則特指那些擁有許多隱藏層的神經網路(通常十層以上),其「深度」使得模型能夠學習到更為抽象和複雜的資料表示。

Transformer:一場基於注意力機制的革命

在Transformer橫空出世之前(特別是2017年Google發表那篇劃時代的論文《Attention Is All You Need》),處理序列資料,例如自然語言,主流的深度學習模型莫過於循環神經網路(Recurrent Neural Network, RNN)及其變體,如長短期記憶網路(Long Short-Term Memory, LSTM)和門控循環單元(Gated Recurrent Unit, GRU)。這些模型透過「記憶」過去的資訊來處理當前的輸入,表現不俗。

然而,RNN/LSTM 有著先天性的缺陷:

-

長距離依賴問題: 當序列非常長時,早期的資訊很容易在傳遞過程中逐漸「衰減」或「遺忘」,導致模型難以捕捉到句子中相隔較遠的詞語之間的關聯性。

-

難以平行化: 由於RNN的計算是序列式的,即前一個時間步的輸出是下一個時間步輸入的一部分,這使得其訓練過程難以在現代多核處理器或GPU上進行大規模的平行運算,大大限制了模型規模的擴展與訓練效率。

這時候,Transformer就像一道閃電劃破了沉寂的天空,它徹底顛覆了傳統,放棄了循環和卷積結構,轉而完全依賴「注意力機制」(Attention Mechanism)。這著實是個大膽的創舉,但它卻意外地帶來了超乎想像的效能提升。

Transformer 的核心部件與運作原理

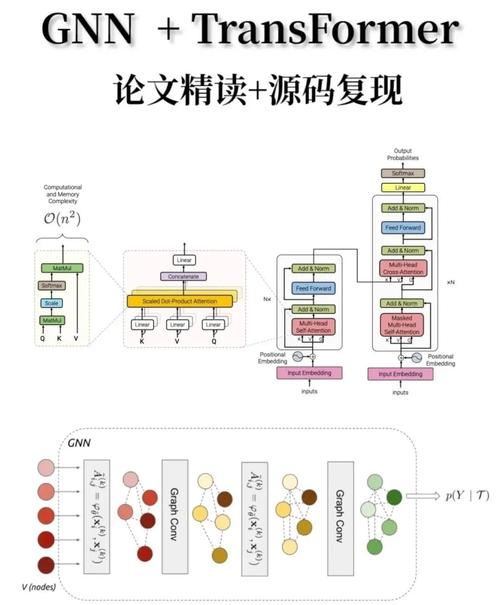

要理解Transformer為什麼能做到這些,我們得先拆解它的「骨架」。Transformer主要由兩種核心區塊堆疊而成:編碼器(Encoder)和解碼器(Decoder)。它們各司其職,共同完成複雜的序列到序列(Seq2Seq)任務,例如機器翻譯。

1. 輸入處理:詞嵌入與位置編碼

在任何資料進入Transformer之前,它們都需要被轉換成模型能夠理解的數值形式。對於文本資料:

-

詞嵌入(Word Embedding): 每個單詞或子詞(Subword)會被轉換成一個固定維度的向量,這些向量能夠捕捉詞語的語義資訊。例如,「貓」和「喵星人」的嵌入向量在向量空間中可能距離很近。

-

位置編碼(Positional Encoding): 這是Transformer的一個精妙之處。由於Transformer不再是序列處理的結構,它本身並沒有「時間」或「位置」的概念。為了讓模型知道詞語在序列中的相對或絕對位置,我們需要向詞嵌入中加入位置資訊。這些位置編碼通常是透過預定義的數學函數(如正弦和餘弦函數)生成,並疊加到詞嵌入向量上。這樣,即便兩個相同的詞出現在不同的位置,它們經過位置編碼後也會有獨特的表示,讓模型能夠區分它們。

2. 編碼器(Encoder)

編碼器的任務是將輸入序列轉換成一系列豐富的上下文表示。一個標準的Transformer通常由多個相同的編碼器層堆疊而成。每個編碼器層主要包含以下兩個子層:

-

多頭自注意力機制(Multi-Head Self-Attention):

這可說是Transformer的「心臟」!自注意力機制讓模型在處理序列中的某個詞時,能夠「關注」到序列中的所有其他詞,並根據這些詞與當前詞的相關性來賦予不同的權重。這就像你在閱讀一篇文章時,當你讀到一個詞,你的大腦會自動回顧文章中所有與這個詞相關的內容,以更好地理解它的含義。

其核心運作涉及三個向量:

- 查詢(Query, Q): 代表當前正在處理的詞。

- 鍵(Key, K): 代表序列中所有其他詞的「標籤」或「特徵」。

- 值(Value, V): 代表序列中所有其他詞的「內容」或「資訊」。

計算方式簡化來說,就是透過計算Q和K的相似度(通常是點積),得到一個注意力分數,然後將這個分數軟化(使用Softmax函數)轉換成權重,最後將這些權重應用到V上,得到當前詞的加權表示。多頭(Multi-Head)的意思是,模型會同時進行多個獨立的注意力計算(每個「頭」都有自己獨立的Q、K、V矩陣),然後將它們的結果拼接起來,這樣模型就能從不同的「注意力角度」來捕捉詞語之間的關係,豐富了模型的表達能力。

-

前饋神經網路(Feed-Forward Network, FFN):

在自注意力層之後,每個位置的輸出會獨立地傳入一個簡單的前饋神經網路。這個FFN通常由兩個線性變換(全連接層)和一個ReLU激活函數組成。它的作用是進一步處理注意力機制提取到的資訊,增強模型的非線性表達能力。

-

殘差連接與層歸一化(Residual Connections & Layer Normalization):

每個子層(自注意力層和FFN層)的輸出都會與其輸入進行殘差連接(Residual Connection),即輸出 = 輸入 + 子層(輸入)。這樣可以有效緩解深度網路訓練中常見的梯度消失問題,使得資訊能夠更容易地在深層網路中流動。接著,殘差連接的結果會通過層歸一化(Layer Normalization),它有助於穩定訓練過程,讓模型更容易收斂。

3. 解碼器(Decoder)

解碼器的任務是根據編碼器的輸出和已經生成的序列部分,逐步生成目標序列。一個標準的Transformer也由多個相同的解碼器層堆疊而成。每個解碼器層包含三個子層:

-

遮罩多頭自注意力機制(Masked Multi-Head Self-Attention):

與編碼器中的自注意力類似,但這裡有一個「遮罩」(Mask)。這個遮罩確保在生成當前詞時,模型只能「看見」已經生成的詞(即它不能偷看未來還未生成的詞),以模擬真實的序列生成過程。這對於像文本生成這類任務至關重要。

-

編碼器-解碼器注意力機制(Encoder-Decoder Attention):

這是解碼器與編碼器溝通的橋樑。解碼器會使用其自身的查詢(Q),去「查詢」編碼器輸出中的鍵(K)和值(V)。這使得解碼器在生成目標序列的每個詞時,能夠關注到輸入序列(來源語言)中相關的部分,實現跨模態的注意力機制,例如在機器翻譯中,它會關注到原始語言中與當前翻譯詞相關的詞語。

-

前饋神經網路(Feed-Forward Network, FFN):

與編碼器中的FFN相同,用於進一步處理資訊。

-

同樣,每個子層之後都有殘差連接與層歸一化。

最後,解碼器的輸出會經過一個線性層和Softmax函數,將其轉換為詞彙表中每個詞的機率分佈,從中選出機率最高的詞作為當前生成步驟的輸出。

我的評論:當我第一次深入學習Transformer的架構時,著實被它那精巧的設計所震撼。特別是自注意力機制的引入,徹底打破了序列模型長期依賴循環結構的桎梏,這不僅解決了長距離依賴的問題,更重要的是,它讓訓練過程能夠高度平行化。這種「attention is all you need」的理念,不僅是一種技術上的突破,更是一種對問題思考方式的革新——從「依序處理」轉變為「全局關聯」。這讓模型能夠同時綜觀全局,捕捉到資料中那些深層次、非線性的潛在模式,真的是個太酷的想法了!

Transformer 是如何「神經」的?核心特徵分析

即便它去除了循環和卷積,但Transformer為何仍被歸類為「神經網路」呢?這並非空穴來風,而是因為它骨子裡繼承了神經網路的所有核心特性:

-

分層的、可學習的轉換: Transformer的每一層(無論是編碼器還是解碼器)都執行著輸入到輸出的非線性轉換。這些轉換中的權重(例如Q、K、V矩陣的權重,以及FFN中的權重)都是可學習的參數。

-

非線性激活: 儘管自注意力機制本身是線性的點積計算,但其後的Softmax函數提供了非線性,而前饋神經網路中更是明確使用了ReLU等非線性激活函數。這些非線性特性讓整個模型能夠逼近任意複雜的函數,處理真實世界中複雜、非線性的資料模式。

-

端到端訓練: Transformer模型通常是透過「反向傳播」和「梯度下降」等傳統神經網路的訓練方法來學習的。從輸入到輸出,整個模型是一個可微分的計算圖,誤差訊號可以有效地反向傳播,以更新所有可學習的參數。

-

層疊式學習抽象特徵: 就像深度神經網路透過多層堆疊來學習越來越抽象、高層次的特徵一樣,Transformer的編碼器和解碼器也透過多層堆疊,逐步提取出輸入資料中更深層次的語義和結構資訊。每一層都在前一層的基礎上進行更複雜的轉換和資訊整合。

-

參數優化: 模型中的數百萬乃至數十億個參數(權重和偏差)都是在訓練過程中,透過最小化損失函數來不斷優化的。這與任何其他類型的人工神經網路的學習過程是完全一致的。

所以說,儘管Transformer在架構上進行了大膽的創新,但其底層的學習機制、參數優化方式以及對非線性特徵的捕捉能力,都與我們理解的神經網路本質相符。它不是一個全新的物種,而是一個在神經網路大家庭中,演化出極其適應現代AI任務的強大分支。

Transformer 如何引領了人工智慧的巨變?

Transformer的出現,絕非只是深度學習領域裡的一個小小的進步,它掀起了一場真正的革命。它的影響力之廣、之深,遠超我們當年所能想像。

1. 自然語言處理(NLP)的黃金時代

要說Transformer最大的貢獻,那莫過於它徹底改變了自然語言處理的格局。它解決了長序列處理的瓶頸,使得模型能夠理解和生成更連貫、更具邏輯的長文本。這直接催生了許多突破性的語言模型:

-

預訓練大模型: 諸如BERT(Bidirectional Encoder Representations from Transformers)、GPT系列(Generative Pre-trained Transformer,如GPT-3、GPT-4)、T5(Text-to-Text Transfer Transformer)等,這些模型首先在海量的無標籤文本資料上進行「預訓練」,學習語言的通用模式和知識。它們的參數量動輒數十億、數千億,甚至上兆。

-

遷移學習的成功: 預訓練好的Transformer模型可以透過少量標籤資料進行「微調」(Fine-tuning),就能在各種下游NLP任務上取得SOTA(State-of-the-Art)表現,例如:

- 機器翻譯: 跨語言翻譯的流暢度和準確度達到前所未有的水準。

- 文本摘要: 自動將長篇文本濃縮成精華摘要。

- 問答系統: 從文本中精準回答問題。

- 情感分析: 判斷文本表達的情緒是正面、負面還是中性。

- 文本生成: 從詩歌、劇本到程式碼、電子郵件,模型的生成能力令人咋舌。我們今天看到ChatGPT等生成式AI的驚人表現,其核心基石正是Transformer。

2. 跨界到電腦視覺(Computer Vision)

一開始,Transformer主要用於NLP,但研究者們很快發現,這種基於注意力的架構也能應用於圖像處理。Vision Transformer(ViT)的出現就是一個里程碑,它將圖像分割成一個個小塊(patches),然後將這些圖像塊視作序列中的「詞元」,再用Transformer進行處理。這證明了Transformer的通用性,並在圖像分類、目標檢測、圖像分割等任務上取得了競爭力,甚至超越了傳統的卷積神經網路(CNN)。

3. 其他領域的應用

Transformer的影響力遠不止於此:

-

語音辨識: 用於處理語音訊號序列,提高辨識準確度。

-

生物資訊學: 在蛋白質結構預測(如DeepMind的AlphaFold 2)和基因序列分析中發揮關鍵作用,這項成就對生命科學領域產生了巨大的影響。

-

推薦系統: 處理使用者行為序列,提供更精準的推薦。

總之,Transformer以其高效的平行化能力、處理長距離依賴的能力,以及強大的學習能力,成為了當前人工智慧領域最為重要的基石之一。它不僅提升了現有任務的效能,更開啟了許多以前無法想像的應用場景,引領我們進入一個由大型預訓練模型驅動的人工智慧新時代。

常見相關問題解析

既然我們已經深入探討了Transformer的本質和運作機制,或許您心中還有一些進一步的疑問。以下,我將針對一些常見問題,提供更詳盡的解答,希望能幫助您更全面地理解這個劃時代的模型。

Transformer和RNN/LSTM有什麼本質上的不同?

雖然Transformer和RNN/LSTM都是用來處理序列資料的神經網路,但它們在核心設計理念上有著根本性的差異,這也解釋了Transformer為何能夠取得突破性的成功。

最核心的區別在於:RNN/LSTM是「序列式」處理,而Transformer是「平行式」處理。 RNN和LSTM依賴於隱藏狀態在時間步上的遞迴傳遞,前一個時間步的計算結果會影響後一個時間步。這使得它們能夠很好地捕捉短期的順序依賴,但當序列過長時,早期的資訊會逐漸衰減,導致「長距離依賴」問題難以解決。此外,這種遞迴結構也使得模型訓練難以進行大規模的平行運算,大大限制了訓練效率和模型規模。

相較之下,Transformer則完全摒棄了遞迴結構。它透過自注意力機制,允許模型在單一時間步內,同時考慮序列中的所有詞元(tokens),並計算它們之間的相關性。這意味著,無論兩個詞元相隔多遠,模型都能直接建立它們之間的聯繫,有效解決了長距離依賴問題。更重要的是,這種注意力機制使得模型可以一次性處理整個序列,這就允許在GPU等硬體上進行高度平行化的計算,極大地加快了訓練速度,並使得訓練超大型模型成為可能。這就是為什麼我們今天能夠看到GPT-3、GPT-4這種擁有數千億參數的模型。

簡而言之,RNN/LSTM就像一個按部就班的讀書人,一個字一個字地讀,讀到後面可能會忘記前面內容;而Transformer則像一個能「一眼看穿」整本書,並同時思考所有詞語關聯的超級大腦。這種處理方式的根本性轉變,是Transformer能夠超越前輩的關鍵所在。

Transformer中的「注意力」機制是怎麼運作的?能否用簡單的例子解釋?

「注意力」機制是Transformer的靈魂。簡單來說,它模擬了人類在處理資訊時,會將注意力集中在最重要部分的行為。想像一下,你在閱讀一句話:「貓在草地上追逐老鼠。」當你想理解「追逐」這個動作是誰做的、追逐的對象是誰時,你的注意力會自然地集中在「貓」和「老鼠」這兩個詞上,而「在草地上」雖然提供了背景資訊,但在理解「追逐」的核心含義時,其重要性相對較低。

Transformer的自注意力機制就是讓模型學會這種「分配注意力」的能力。它透過計算序列中每個詞元與所有其他詞元之間的相似度,來決定哪些詞元對當前詞元的理解更為重要。這個過程抽象為Query(查詢)、Key(鍵)和Value(值)三個向量:

-

Query (Q): 可以想像成你正在「查詢」或「詢問」當前詞元的含義。例如,對於詞元「追逐」,Query就是它的「意圖向量」。

-

Key (K): 序列中所有其他詞元(包括「貓」、「在」、「草地」、「上」、「老鼠」)都有一個Key向量,可以看作是它們的「標籤」或「索引」。

-

Value (V): 序列中所有其他詞元也都有一個Value向量,代表了它們的「實際內容」或「資訊」。

運作流程是:

-

模型會計算當前詞元Q向量與所有其他詞元K向量的相似度(通常是點積)。這個相似度越高,說明它們之間的關聯性越強。

-

這些相似度得分會經過Softmax函數轉換成機率分佈,作為「注意力權重」。這些權重指示了當前詞元在理解時應該對其他詞元「關注」多少。

-

最後,將這些注意力權重乘上對應的V向量,並加總起來,就得到了當前詞元的新的、富含上下文資訊的表示。這個新的表示融合了序列中所有相關詞元的資訊,而且是根據它們的相關程度進行加權的。

多頭注意力則是在此基礎上,同時進行多組獨立的Q、K、V計算,每個「頭」可以學習到不同的注意力模式或資訊維度。例如,一個頭可能關注語法關係,另一個頭可能關注語義關係。這樣多個「視角」的結合,使得模型能夠更全面、更細緻地捕捉複雜的上下文依賴關係,大大增強了模型的表達能力和魯棒性。

為什麼說Transformer比傳統神經網路更「強大」?

當我們說Transformer「更強大」時,主要是基於以下幾個維度來考量的:

1. 處理長距離依賴的能力: 這是Transformer最顯著的優勢。透過自注意力機制,它能夠直接建立序列中任意兩個位置之間的連接,而不會像RNN/LSTM那樣隨著距離增加而「遺忘」資訊。這對於理解長篇文件、捕捉複雜語義關係至關重要。

2. 高效的平行化能力: 前面提過,Transformer的非遞迴設計允許其在訓練時進行高度平行化運算。這使得我們可以在短時間內訓練出數十億、數千億甚至上兆參數的超大型模型。傳統的RNN/LSTM在面對如此龐大的資料和模型規模時,其訓練時間將變得難以承受。

3. 卓越的表示學習能力: Transformer能夠從海量資料中學習到極其豐富和抽象的資料表示(embeddings)。這些表示不僅包含詞語本身的語義資訊,更融入了其在不同上下文中的複雜語義和句法資訊。這些高品質的表示是後續各種下游任務成功的基石。

4. 遷移學習的範式革新: Transformer將「預訓練-微調」的範式推向了極致。在通用的大型數據集上(例如整個網際網路的文本)進行預訓練,讓模型學習通用知識,然後再針對特定任務(如情感分析、問答)進行少量數據的微調。這種方式極大地降低了開發新AI應用的門檻,因為不需要從零開始訓練模型,只需在預訓練模型基礎上進行高效的客製化即可。

5. 模型的通用性: Transformer的設計理念具有很強的通用性。最初為NLP設計,但後來被成功地應用於圖像、語音甚至化學和生物學領域,證明了其在處理序列或類序列資料方面的廣泛適用性。這種「一通百通」的特性,讓研究者和開發者能夠用一套相對統一的框架來解決不同領域的問題。

總體而言,Transformer的強大在於它克服了舊有模型的瓶頸,使得模型可以更大、訓練更快、學得更好,從而開啟了人工智慧應用的新紀元。

Transformer有哪些主要類型?

雖然《Attention Is All You Need》論文中提出了典型的編碼器-解碼器結構,但在實際應用中,根據任務需求,Transformer已經演變出幾種主要的變體:

1. 編碼器-解碼器結構(Encoder-Decoder Architecture):

-

代表模型: 原始Transformer、T5(Text-to-Text Transfer Transformer)。

-

適用場景: 主要用於序列到序列的任務,即輸入是一個序列,輸出也是一個序列,例如機器翻譯(將一種語言的句子翻譯成另一種語言)、文本摘要(將一篇長文章總結成一段短文)。編碼器負責理解輸入序列,解碼器負責根據編碼器的理解生成輸出序列。

-

特點: 編碼器部分允許「雙向」注意力,即在理解每個詞時可以參考整個輸入序列;解碼器部分則採用「遮罩自注意力」,確保在生成當前詞時只能看到已經生成的詞,保持生成過程的順序性。

2. 純編碼器結構(Encoder-Only Architecture):

-

代表模型: BERT(Bidirectional Encoder Representations from Transformers)、RoBERTa、DistilBERT等。

-

適用場景: 主要用於需要理解文本但不需要生成新文本的任務,例如文本分類(判斷評論的情緒)、命名實體識別(識別文本中的人名、地名)、問答系統(從給定文本中找到答案)。這類任務通常需要模型對輸入文本進行深度的雙向理解。

-

特點: 模型只包含多個堆疊的編碼器層。由於編碼器允許雙向注意力,這類模型在理解文本上下文方面表現出色,能夠捕捉到詞語在前後文中的複雜關係。

3. 純解碼器結構(Decoder-Only Architecture):

-

代表模型: GPT系列(Generative Pre-trained Transformer,如GPT-2、GPT-3、GPT-4)、LLaMA、PaLM等。

-

適用場景: 主要用於文本生成任務,即給定一個開頭或提示,模型需要生成連貫的後續文本,例如寫文章、寫詩、聊天機器人對話生成、程式碼生成等。這類任務強調模型的單向生成能力。

-

特點: 模型只包含多個堆疊的解碼器層,但移除了編碼器-解碼器注意力機制。每個解碼器層中的自注意力機制都帶有遮罩,確保在生成每個詞時,模型只能依賴於它前面已經生成的詞,這模擬了人類逐字或逐詞寫作的過程。這種單向性使得模型在生成連續、邏輯嚴謹的文本方面表現優異。

這三種基本類型構成了當前Transformer模型家族的基石,它們各有所長,共同推動著人工智慧的進步。

Transformer的缺點是什麼?

儘管Transformer的優勢令人矚目,但它並非完美無缺,也有其固有的局限性:

1. 計算資源消耗巨大: 這是Transformer最為人詬病的一點。自注意力機制的計算複雜度與序列長度的平方成正比(O(N^2),其中N是序列長度)。這意味著,當處理非常長的序列(例如數萬個詞元)時,計算成本會呈指數級增長,導致記憶體耗用和計算時間急劇增加。這限制了Transformer在某些需要處理極長序列的場景中的應用,例如基因組分析或超長文件理解。

2. 記憶體需求高: 除了計算複雜度高,Transformer在訓練和推理過程中也需要大量的記憶體來儲存Q、K、V矩陣以及中間的注意力權重矩陣。對於大型模型和長序列,這對硬體的要求非常高,一般消費級的GPU往往難以負荷。

3. 對於位置資訊的依賴(需要額外的位置編碼): 由於自注意力機制本身是「無序」的(它不關心詞元在序列中的絕對位置),Transformer需要額外引入位置編碼來告知模型詞元在序列中的順序資訊。雖然位置編碼解決了這個問題,但這也意味著模型需要額外的設計來處理序列的順序性,而不是像RNN那樣天生就具有這種能力。

4. 對於小型數據集可能存在過擬合風險: 儘管大型Transformer模型在預訓練階段展現了驚人的泛化能力,但如果將其直接應用於非常小的下游任務數據集,且不進行充分的微調或正規化,仍然可能出現過擬合(Overfitting)的問題。這是因為模型的參數量巨大,具備極強的學習能力,如果數據量不足,模型可能會記住訓練數據的噪音,而不是學習到真正的泛化模式。

為了克服這些缺點,研究人員們也提出了許多改進措施,例如稀疏注意力(Sparse Attention)、線性注意力(Linear Attention)等,試圖降低計算複雜度;也有針對性地優化模型架構,使其在不同場景下更高效。即便如此,Transformer依然是當前人工智慧領域無可替代的基石,其帶來的變革是前所未有的。

結語:Transformer,深度學習的輝煌篇章

回到文章開頭的疑問:「Transformer 是神經網路嗎?」相信經過這一路的探索,答案已經再清晰不過了。它不僅僅是神經網路,更是深度學習發展歷程中一個里程碑式的存在。它以注意力機制為核心,突破了傳統序列模型的瓶頸,實現了前所未有的平行化能力和長距離依賴捕捉能力,徹底改寫了自然語言處理乃至整個AI領域的遊戲規則。

Transformer的成功,再次證明了人工智慧領域的活力與無限可能。它讓我們看到了,透過巧妙的架構設計和對計算效率的追求,神經網路可以被推向何等令人驚訝的高度。從它孕育出BERT、GPT等一系列「巨無霸」模型,再到其應用範圍拓展至圖像、語音、甚至生命科學,Transformer的影響力已然無遠弗屆。

即便它也有著運算耗費巨大的缺點,但它的誕生與普及,毋庸置疑地為我們揭開了人工智慧一個新的黃金時代的序幕。它不僅僅是一個技術名詞,更是人工智慧領域中創新、深度與實用主義完美結合的象徵,著實令人心潮澎湃!