實例分割:超越物件偵測,為AI視覺注入精準邊界與感知智能

Table of Contents

實例分割:為AI視覺世界畫出清晰邊界,究竟是什麼?

想像一下,您正開發一款智慧監控系統,希望它不只偵測到畫面上「有人」,更要精準地知道「哪些像素屬於這個人」、「哪些像素屬於另一個人」,甚至在人群中能清楚區分每個個體,而且還要在背景複雜、光線不佳的環境下也能辦到。哇!這聽起來是不是有點像科幻電影裡的場景啊?但這可不是天方夜譚,這正是當今人工智慧(AI)視覺領域中一個非常強大、且日益普及的技術——實例分割(Instance Segmentation)。

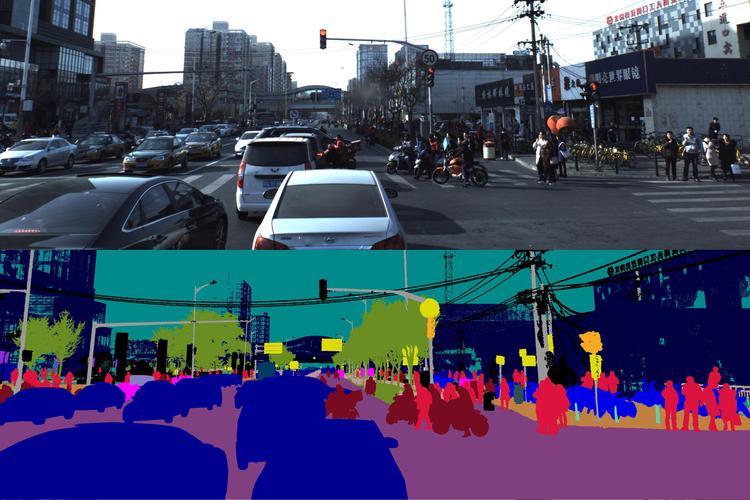

簡單來說,實例分割是一種比傳統物件偵測(Object Detection)和語義分割(Semantic Segmentation)更進階的電腦視覺技術。它不僅能夠像物件偵測那樣,在圖片或影片中「框選」出感興趣的物體(例如:一個人、一台車、一棵樹),更厲害的是,它還能做到語義分割那樣,為每個物體「精確地描繪出像素級別的輪廓」。而且,最關鍵也最困難的點來了:它能同時區分出同一個類別的不同「實例」!舉例來說,一張圖片裡有三個人,物件偵測會給你三個方框;語義分割會把所有人的像素都標記成「人」這個類別,顏色可能都一樣;但實例分割呢?它會為這三個人分別繪製出三個「獨立且精確」的像素級別輪廓,並能清楚區分這是「人1」、「人2」和「人3」。這種能力,簡直是為AI視覺注入了一種前所未有的「精準感知」啊!

它就像一位超級厲害的繪畫大師,不只知道畫面上有些什麼東西,更能細緻入微地勾勒出每個獨立物體的每一條邊界,連頭髮絲、衣服皺褶都能給你描繪出來,是不是很神奇呢?這項技術在許多領域都扮演著舉足輕重的角色,尤其是在需要高度精準識別和細節理解的應用場景中,它簡直是不可或缺的喔!

實例分割的魔力:為何它比物件偵測和語義分割更勝一籌?

要深入理解實例分割的魅力,我們得先快速回顧一下它在「兄弟姊妹」中的位置。在電腦視覺家族裡,物件偵測、語義分割和實例分割,就像三兄弟,一個比一個厲害,解決的問題也越來越複雜。

- 物件偵測(Object Detection): 這是入門級的辨識任務,目標是找出圖片中所有感興趣的物件,並用一個「最小外接矩形」也就是「邊界框(Bounding Box)」把它們框起來,同時標註出是什麼物件。例如,在一張街道圖片裡,它會告訴你:「這裡有一輛車、那裡有兩個人。」並用框標示出來。它的優點是速度快、效率高,但缺點也很明顯:邊界框內可能包含背景雜訊,而且無法區分同類物體。

- 語義分割(Semantic Segmentation): 這就進階多了,它不再是畫框框,而是進行「像素級別」的分類。想像一下,它會把圖片中的每個像素都歸類到特定的語義類別中。例如,所有屬於「車」的像素都會被標記為車,所有屬於「人」的像素都會被標記為人。這樣一來,你就得到了每個物體的精確輪廓了!這聽起來很棒對吧?但它有個小小的遺憾:它無法區分同一個類別中的不同「實例」。如果你圖片裡有兩輛車緊挨著,它可能會把這兩輛車的所有像素都標記成「車」,並無法告訴你這是「車A」還是「車B」。這在很多需要區分個體的應用中就成了瓶頸。

- 實例分割(Instance Segmentation): 這就是我們的主角啦!它集兩者之大成,甚至更超越。實例分割不僅能識別出每個物體是什麼,還能像語義分割一樣,為每個物體提供「像素級別的精確遮罩(Mask)」,更重要的是,它還能區分出每個「獨立的實例」。所以,如果圖片裡有兩輛車,它會分別給你「車A」的像素級遮罩和「車B」的像素級遮罩,清楚明瞭,互不干擾。這也正是實例分割的「魔法」所在,它讓AI對世界的感知能力提升到了一個新的層次!

為了讓大家更清楚地理解這三種技術的差異,我來為大家整理一個表格,這樣一目瞭然喔!

| 技術名稱 | 輸出形式 | 主要能力 | 是否區分同類實例 | 應用場景舉例 |

|---|---|---|---|---|

| 物件偵測 (Object Detection) | 邊界框 (Bounding Box) + 類別標籤 | 物體定位與分類 | 否 | 人臉識別、商品掃碼、交通監控 |

| 語義分割 (Semantic Segmentation) | 像素級別的類別標籤 (遮罩) | 像素級物體分類 | 否 | 自動駕駛車道線識別、醫學影像器官分割 |

| 實例分割 (Instance Segmentation) | 像素級別的實例標籤 (獨立遮罩) | 物體定位、分類,並區分獨立實例的精確輪廓 | 是 | 自動駕駛中行人/車輛區分、機器人抓取、精準醫療影像分析 |

看到了嗎?實例分割的「像素級別區分實例」能力,才是真正讓它在眾多應用中脫穎而出的關鍵呢!

實例分割是如何辦到的?深度學習模型的奇妙架構

您可能會好奇,這麼厲害的功能,AI模型到底怎麼實現的呢?這就要歸功於近年來深度學習技術的飛速發展,特別是卷積神經網路(Convolutional Neural Networks, CNNs)的進步。實例分割的經典方法大多是建立在兩階段或單階段的物件偵測器之上,並加入了一個預測像素級遮罩的分支。

Mask R-CNN:實例分割的里程碑級模型

談到實例分割,就絕對不能不提到Mask R-CNN這個模型。它是由Facebook AI Research (FAIR) 於2017年提出的,一經問世便成為實例分割領域的標竿,至今仍是許多研究和應用的基礎。它巧妙地將物件偵測和實例分割整合在一個統一的架構中,可以說是非常優雅且高效的設計。

Mask R-CNN 的核心思想,其實是基於Faster R-CNN這個物件偵測模型進行擴展的。它在Faster R-CNN的基礎上,額外增加了一個「分支」來預測每個物件的像素級遮罩。我們來一步步拆解它的工作流程,您會發現它其實很有趣喔:

-

主幹網路 (Backbone Network):

首先,一張輸入圖片會被丟進一個深度卷積神經網路,這通常會是一個預訓練好的分類網路,像是ResNet或ResNeXt。這個網路的功能是「提取圖片中的各種特徵」。你可以想像它就像一個經驗豐富的偵探,在圖片中搜尋著各種線索,從淺層的邊緣、紋理,到深層的語義資訊,都給它提煉出來。這些特徵對於後續的偵測和分割都至關重要喔!

-

區域提案網路 (Region Proposal Network, RPN):

在主幹網路提取完特徵之後,這些特徵圖會被送入RPN。RPN的任務是「生成潛在的物體候選區域」。它會快速掃描特徵圖,提出大量可能包含物體的「區域提案(Region Proposals)」,每個提案都是一個矩形框,並且會判斷這個框裡是不是有物體(前景/背景分類)以及精修一下框的位置。這就像一個初篩的過程,快速篩選出數百到上千個可能的物體位置。

-

RoIAlign 層 (Region of Interest Align):

這是Mask R-CNN相比Faster R-CNN的一個關鍵改進!在Faster R-CNN中,用於將不同大小的區域提案轉換為固定大小特徵圖的層是RoIPooling,但RoIPooling會進行量化操作(取整),這會導致一些精確位置資訊的丟失。對於物件偵測來說,這點損失可能還好,但對於像素級別的遮罩預測來說,哪怕一點點的對齊誤差都會嚴重影響遮罩的精準度。

而RoIAlign則採用了「雙線性插值(Bilinear Interpolation)」的方式,避免了量化誤差,確保了從原始特徵圖中提取的特徵與原始圖像的像素對齊更加精確。這對於生成高品質的像素級遮罩來說,簡直是至關重要的一步啊!這就好像一個畫家在描繪細節時,堅持使用最精確的工具,不允許任何一點點的失真。 -

分類、邊界框回歸與遮罩預測頭 (Classification, Bounding Box Regression and Mask Head):

經過RoIAlign處理後的固定大小特徵圖,會被送入三個並行的「頭部」網路:

- 分類頭: 這個頭會判斷每個RoI到底是什麼類別的物體(例如:是人、是車還是其他)。

- 邊界框回歸頭: 這個頭會對RPN初步生成的邊界框進行精細調整,讓它更準確地包圍住物體。

- 遮罩預測頭: 這就是Mask R-CNN的「點睛之筆」啦!這個頭會為每個經過分類且精修過邊界框的RoI,生成一個二值遮罩(Binary Mask)。這個遮罩的尺寸通常比較小,但會被放大回原始RoI的大小,精確地指示出哪些像素屬於這個物體。這個過程就像為每個找到的物體量身定做一件「像素禮服」,保證合身!

整個過程一氣呵成,從粗略的物體定位到精確的像素級分割,Mask R-CNN的設計思想非常值得學習。它成功地證明了,在物件偵測的基礎上,加入一個輕量級的遮罩分支,就能實現強大的實例分割能力。

其他實例分割模型:多元發展的生態

當然,除了Mask R-CNN之外,實例分割領域還有許多其他優秀的模型和方法,它們各自有其特色和適用場景:

- YOLACT / BlendMask: 這兩類模型屬於「單階段」實例分割器,它們的設計目標是實現「即時(Real-time)」的實例分割。與Mask R-CNN的兩階段方法不同,它們嘗試在一個網路前向傳播中同時完成物體偵測和遮罩預測,大大提升了推理速度。這對於像自動駕駛這種需要極低延遲的應用來說,非常重要喔!不過,通常在精度上可能會比兩階段模型略有犧牲。

- SOLOv2 (Segmenting Objects by Locations v2): 這是一個比較新的、很有趣的方法,它將實例分割任務「解耦」成兩個平行的子任務:一個用於預測物體類別的「實例核(instance kernel)」,另一個用於預測每個像素位置的「特徵輸出(feature map)」。然後通過矩陣乘法,將核與特徵輸出結合起來生成實例遮罩。這種方法非常簡潔,並且在精度和速度上都取得了很好的平衡。我個人覺得這類模型很有潛力,未來可能會看到更多類似的簡潔高效架構。

- PolarMask / Slicing Aided Hyper Inference (SAHI) 等: 還有一些模型嘗試從不同的角度來解決實例分割問題,例如PolarMask通過預測極座標下的輪廓來生成遮罩。而像SAHI這類技術,則是透過對大尺寸圖片進行切片處理,再將結果合併,來提升對小物件的偵測和分割效果,這在遙感影像或醫學影像中非常實用。

模型這麼多,是不是有點眼花撩亂啊?但這也說明了這個領域的活力和多元性。不同的模型有不同的優勢,選擇哪一種,往往要根據實際應用對精度、速度和計算資源的要求來權衡。

實例分割的實際應用:從科幻到現實的橋樑

實例分割技術可不是只停留在學術論文裡的概念喔!它已經在我們的日常生活中,以及許多高科技產業中,發揮著越來越重要的作用。它的精準像素級別感知能力,讓許多以往難以實現的應用變成了可能。

1. 自動駕駛與先進駕駛輔助系統(ADAS)

這是實例分割最引人注目的應用之一!在自動駕駛中,車輛需要對周圍環境有極其精確的理解。它不僅要知道哪裡有車、哪裡有人,更要能明確區分出「每輛車的輪廓」、「每個行人的形狀」,甚至連「路燈」、「交通標誌」等都需要被精準分割出來。

我的觀察是,實例分割在幫助自駕車識別潛在碰撞風險、規劃安全路徑、以及區分不同道路使用者方面,扮演著至關重要的角色。例如,它能區分擁擠車流中的每一輛車,以便計算每輛車的速度和距離,避免追撞;也能精確識別出穿越馬路的行人,即使人群中有部分遮擋,也能大概率推斷出每個個體的輪廓,確保行車安全。沒有實例分割,自動駕駛的精準決策可能就會大打折扣,這可是攸關生命安全的大事啊!

2. 醫學影像分析

在醫療領域,實例分割簡直就是「AI醫生」的得力助手。

- 腫瘤分割與量化: 醫生可以利用實例分割模型,在CT、MRI等醫學影像中精準地分割出腫瘤、病變區域,甚至能區分出多個獨立的病灶。這對於評估病情、制定治療方案、監測治療效果(例如腫瘤體積變化)來說,提供了無可比擬的精確數據。這比人工手動標註要高效得多,而且能減少主觀性誤差。

- 細胞計數與形態學分析: 在病理切片分析中,實例分割能自動區分並計數不同類型的細胞,分析其形狀、大小和分佈。這對於診斷癌症、血液疾病等非常有幫助。

- 器官分割: 在手術規劃或放射治療中,精準地分割出各個器官的輪廓,對於保護周圍健康組織、提升治療效果至關重要。

我個人在一些研究項目中見證過實例分割在醫療影像上的應用,那精準度真是令人驚嘆。它真的能幫助醫生更快、更準確地做出判斷,甚至能發現肉眼難以察覺的細微變化,極大地提升了醫療效率和診斷水平。

3. 機器人學與自動化

機器人要與真實世界互動,就必須「看懂」世界。實例分割為機器人提供了精確的環境感知能力。

- 物體抓取與操作: 想像一下,一個機器手臂要從一堆混亂的零件中抓取一個特定的螺絲,或者在生產線上組裝複雜的產品。它需要知道每個零件的精確位置和輪廓,才能規劃出最佳的抓取點和抓取姿態。實例分割就能提供這種像素級別的幾何資訊,讓機器人能夠「輕手輕腳」地完成複雜任務。

- 自主導航與避障: 在倉庫、工廠或醫院等環境中,服務型機器人或無人搬運車(AGV)需要自主導航。實例分割可以幫助它們精準地識別並區分出各種障礙物、貨物、通道和人員,從而規劃出最優的路徑並安全地避開障礙。

4. 擴增實境(Augmented Reality, AR)與虛擬實境(Virtual Reality, VR)

AR/VR的核心就是要將虛擬內容與現實世界無縫融合。而要做到這一點,就必須對現實環境有非常深入的理解。

- 環境理解與互動: 實例分割可以幫助AR應用精準地識別出真實世界中的物體表面,例如一張桌子、一面牆壁、一個人。這樣,虛擬的物件就可以「真實地」放置在這些表面上,並且能夠實現遮擋效果,讓虛擬物體看起來就像真實存在於環境中一樣。例如,你在手機AR應用中放置一隻虛擬的貓咪,它能「站」在你的沙發上,當你走過它面前時,貓咪會被你遮擋住,這就是實例分割在幕後發揮作用喔!

- 虛擬試穿/試戴: 想像一下,你可以在手機上虛擬試穿新衣服、新鞋子,或者虛擬試戴眼鏡。實例分割能夠精準地識別出你身體的各個部位,然後將虛擬的衣物精準地「穿」在你身上,而且還能根據你的動作自然地變化,是不是很酷啊?

5. 零售與庫存管理

在智慧零售領域,實例分割也能發揮大作用。

- 自動貨架盤點: 電商或實體店鋪可以用實例分割技術,對貨架上的商品進行自動識別和計數,精準掌握庫存數量,大大提高盤點效率,減少人工錯誤。

- 顧客行為分析: 透過對店內顧客和商品的實例分割,可以更精確地分析顧客的購物路徑、在哪些商品前停留時間長,以及與商品的互動方式,為零售商提供寶貴的商業洞察。

這些應用只是冰山一角,實例分割的潛力非常巨大。它為電腦提供了一雙更「銳利」的眼睛,讓AI能以更精細的粒度理解視覺世界,進而推動各行各業的創新。

訓練一個實例分割模型:數據與挑戰

要讓實例分割模型發揮作用,當然離不開大量的數據訓練。而這也是整個流程中最「痛」但又最關鍵的一環:數據標註(Data Annotation)。

1. 數據準備與標註:像素級的「繡花功夫」

訓練一個高效能的實例分割模型,需要大量的帶有「像素級遮罩」的圖像數據。這可不是像物件偵測那樣畫個框框就完事了,這要求標註人員為圖片中每個感興趣的物體,精確地勾勒出其輪廓線,生成一個二值遮罩。例如,如果你要識別圖片中的行人,你就需要把每個行人的輪廓都仔細地描出來,確保每個像素都歸屬正確。這項工作通常是:

- 耗時耗力: 相比於物件偵測或圖像分類的標註,像素級的實例分割標註工作量是呈指數級增長的。一張圖片裡如果有多個物體,每個物體都需要精細描邊,這真的是非常考驗耐心和細緻程度的「繡花功夫」。

- 專業性要求高: 特別是在醫學影像等領域,標註人員需要具備一定的專業知識,才能正確識別和勾勒出病灶或器官的邊界。

- 成本高昂: 由於工作量大、對標註人員要求高,實例分割數據集的標註成本通常會比其他類型數據集高出許多。

不過,現在也有一些半自動化的標註工具,可以利用預訓練模型先生成初步的遮罩,再由人工進行修正,這樣可以大大提高效率。儘管如此,數據標註依然是實例分割部署面臨的一個主要挑戰。

2. 訓練過程:模型優化與微調

一旦有了足夠的標註數據,接下來就是模型的訓練環節了。這個過程與其他深度學習模型的訓練類似,但有其獨特的損失函數構成:

-

損失函數: Mask R-CNN這類模型通常會綜合考量多種損失:

- 分類損失: 用於確保模型能正確判斷物體的類別。

- 邊界框回歸損失: 用於精修物體邊界框的位置。

- 遮罩損失: 這是實例分割特有的部分,通常使用二值交叉熵損失(Binary Cross-Entropy Loss),用於評估預測遮罩與真實遮罩之間的差異。

這三種損失會被加權求和,共同引導模型進行優化。

- 優化器: 常用Adam、SGD等優化器來更新模型參數。

- 硬體要求: 由於實例分割模型的計算量和記憶體佔用較大,通常需要高性能的GPU來進行訓練,特別是當處理高解析度圖像或大批量數據時。

3. 挑戰與考量:完美從來不易

雖然實例分割功能強大,但實際部署和應用時,我們還是會遇到一些挑戰:

- 計算複雜度高: 相比於僅僅預測邊界框的物件偵測模型,實例分割需要進行額外的像素級預測,這導致其模型通常更大、計算量更高,推理速度也相對較慢。這對於即時性要求高的應用(如自駕車)來說,是個需要克服的難題。

- 遮擋處理: 當多個同類物體相互遮擋時,模型很難精準地識別出每個獨立個體的完整輪廓。例如,人群中有人被另外的人遮擋住了一部分身體,模型要麼會將他們識別成一個整體,要麼會對被遮擋部分的輪廓預測失準。這依舊是個活躍的研究領域。

- 小物件識別: 圖片中如果物體很小,它們所佔據的像素點很少,模型很難從如此少的資訊中提取出足夠的特徵來進行精準的分類和分割。這需要更精細的特徵提取網路或特定的策略來解決。

- 數據不平衡: 某些類別的物體在數據集中可能很少見,這會導致模型對這些少數類別的識別能力較差。

儘管存在這些挑戰,但研究人員和工程師們正在不斷探索新的模型架構、訓練策略和數據增強技術來克服它們。技術的進步速度,總是能不斷給我們帶來驚喜啊!

我個人對實例分割的一些看法與經驗分享

在我接觸AI視覺這麼多年,實例分割一直是我認為「最貼近人類視覺感知」的技術之一。物件偵測像是在用放大鏡看世界,框出重點;語義分割則像用不同的顏色筆標記區域,分門別類;而實例分割呢,它更像是人類用肉眼去細緻觀察,能一眼區分出面前的兩個人是不同的個體,即使他們穿著相似的衣服。這種「個體化」的識別能力,正是它最讓我感到驚艷的地方。

我記得有一次,我們在做一個智慧零售的專案,需要精確識別貨架上每一件商品的SKU(庫存單位)以及它們的數量。傳統的物件偵測雖然能框出商品,但遇到擺放密集、商品堆疊的情況時,就很容易數錯或者把兩個獨立的商品當成一個。這時候,實例分割就展現了它的強大威力。它能夠為每個單品生成獨立的遮罩,即使商品之間緊密相連,也能被清晰地分割開來。雖然一開始數據標註的成本確實不低,但一旦模型訓練好,部署後帶來的效益,例如精準的庫存管理、及時的缺貨提醒,遠遠超出了初始的投入。那種看著模型在複雜場景中精準地分割出每一件商品的感覺,真的挺有成就感的!

當然,我也遇到過一些「頭痛」的問題。比方說,在處理一些極端環境(像是夜晚低光照、或者嚴重霧霾)下的影像時,模型的表現就會明顯下滑。畢竟,模型再厲害,也還是要依賴輸入影像的品質。另外,處理高解析度影像時,運算資源的需求會大幅增加。如何找到速度和精度之間的最佳平衡點,永遠是個需要不斷權衡的課題。在某些對即時性要求極高的場景,我們可能需要犧牲一點點精度,選擇像YOLACT這樣更輕量級的模型;而在醫療影像這類對精度要求絕對優先的場景,即使推理速度慢一點,Mask R-CNN這種高精度模型依然是首選。

總的來說,實例分割技術正在持續演進,新的模型和優化方法不斷湧現。它不僅僅是一個技術名詞,更是賦予AI理解複雜視覺世界的「眼睛」和「大腦」,我相信它在未來會開拓出更多令人驚豔的應用領域!

實例分割常見問題與專業解答

Q1:實例分割和語義分割有什麼不同?它們的功能是不是很像?

這個問題很棒,確實很多人會把實例分割和語義分割搞混,因為它們都涉及到像素級的圖像理解。但它們的核心區別,就在於「是否區分同類實例」。

語義分割(Semantic Segmentation)的目標是為圖片中的每個像素點進行「分類」,也就是說,把所有屬於「車」的像素都標記為「車」,所有屬於「人」的像素都標記為「人」。它輸出的是一張「語義地圖」,每個像素都被賦予一個語義標籤。因此,如果一張圖片裡有三輛車,語義分割會把這三輛車的所有像素都歸為一個「車」的類別,它們會顯示為同一種顏色,你無法從語義分割的結果中區分出「車1」、「車2」、「車3」。它關注的是「這個區域是什麼東西」。

而實例分割(Instance Segmentation)則更進一步,它不僅對每個像素進行分類,還能夠在同一個類別中「區分不同的實例」。也就是說,如果圖片裡有三輛車,實例分割會為「車1」生成一個獨立的像素級遮罩,為「車2」生成另一個獨立的遮罩,為「車3」生成第三個獨立的遮罩。它們雖然都屬於「車」這個類別,但每個都會被識別為一個獨立的個體。它關注的是「這個區域是哪個東西」。

簡單來說,語義分割是「找出所有車在哪裡」,實例分割是「找出每一輛車分別在哪裡」。在需要個體識別的應用中,例如機器人抓取特定物品、自駕車區分每個行人和車輛,實例分割就顯得不可或缺了。

Q2:實例分割在自動駕駛領域扮演什麼角色?為何它如此重要?

實例分割在自動駕駛領域扮演著「眼睛」和「大腦」的關鍵角色,重要性不言而喻。它為自動駕駛系統提供了前所未有的精準環境感知能力,使得車輛能夠做出更安全、更智慧的決策。

首先,自駕車需要識別路面上的所有物體,包括車輛、行人、自行車、交通標誌、交通錐等等。傳統的物件偵測雖然能框選這些物體,但無法區分開緊密相連的個體,也無法提供物體的精確形狀。例如,如果行人之間有部分遮擋,物件偵測可能只能框出一個大範圍,無法明確每個行人的邊界。這對於精確判斷每個行人的運動軌跡、預測其下一步行為來說,是遠遠不夠的。

而實例分割則能為每一個獨立的物件(例如每一輛車、每一個行人)提供像素級別的精確輪廓。這帶來了多方面的好處:

- 精準避障與路徑規劃: 透過精確的物體輪廓,自駕車能更準確地判斷障礙物的實際佔用空間,規劃出最佳的避讓路徑,避免不必要的急轉彎或急剎車。

- 精確追蹤與行為預測: 能夠區分並追蹤每個獨立的行人或車輛,對於預測它們的下一步行動至關重要。例如,當一個行人在車流中穿越馬路時,實例分割能精確定位其位置和輪廓,幫助車輛判斷是否需要減速或停車。

- 區分可通行區域與非通行區域: 實例分割可以精確地將道路、人行道、綠化帶、建築物等進行分割,幫助車輛判斷哪些區域是可通行的,哪些是障礙。

- 惡劣天氣下的魯棒性: 雖然仍有挑戰,但在雨雪等惡劣天氣下,精細的像素級分割能提供更多視覺線索,幫助系統更好地識別模糊或部分遮擋的物體。

可以說,沒有實例分割提供的精確細節,自動駕駛系統對環境的理解將會大打折扣,許多複雜的行車決策也將難以實現。它是將自駕車從「能走」提升到「安全且智慧地走」的關鍵技術之一。

Q3:訓練一個實例分割模型需要哪些資料準備?有沒有什麼特別的工具?

訓練一個實例分割模型,最關鍵也最耗時的部分就是「資料準備」,特別是「標註」的環節。

您需要準備大量的圖片(或影片幀),然後對這些圖片中的每一個你感興趣的目標物體進行「像素級別的輪廓標註」。這意味著,您不能像物件偵測那樣只畫一個矩形框,而是要非常精確地描繪出物體的每一條邊界,生成一個二值遮罩(Binary Mask)。如果一個圖片裡有三個人,您就需要為這三個人分別描繪出三個獨立的、精確到像素的輪廓。這項工作需要極大的耐心和細緻程度。

具體來說,資料準備的步驟大致如下:

- 圖片/影片採集: 收集與您的應用場景相符的原始圖像或影片數據。確保數據的多樣性,包括不同光照、角度、背景、遮擋情況等。

- 標註工具選用: 這一步是重點!由於像素級標註的複雜性,必須依賴專業的標註工具。市面上有許多開源和商業的實例分割標註工具,常見的包括:

- Labelme: 一款非常流行的開源標註工具,支援多邊形、矩形、圓形等標註模式,可以輸出JSON格式的標註文件,其中包含每個物體的像素級多邊形座標。它簡單易用,適合小團隊或個人使用。

- VGG Image Annotator (VIA): 另一款基於瀏覽器的開源工具,也支援多邊形標註,輕量級且方便部署。

- RectLabel: macOS平台上的專業標註工具,功能豐富,支援各種標註任務。

- Labelbox / SuperAnnotate 等商業平台: 如果您有大量的數據需要標註,或者需要團隊協作、質量控制等功能,可以考慮這些專業的雲端標註平台。它們通常提供半自動化標註功能(如SAM模型輔助標註),能大大提高效率。

- 進行標註: 使用選定的工具,按照您的定義,對每一張圖片中的每一個目標實例進行精細的輪廓勾勒。務必確保標註的準確性和一致性。這一步的質量直接決定了模型最終的表現。

- 資料集格式化: 標註完成後,通常會將標註結果轉換為模型訓練所需的特定格式,例如COCO格式(Common Objects in Context)。COCO格式是一種廣泛使用的數據集格式,它結構清晰,包含圖像資訊、物體邊界框、像素級遮罩等多種資訊,方便深度學習框架直接載入訓練。

- 數據集劃分: 將標註好的數據集劃分為訓練集(Training Set)、驗證集(Validation Set)和測試集(Test Set)。通常比例為8:1:1或7:1:2,訓練集用於模型學習,驗證集用於調優參數和監控訓練進度,測試集則用於最終評估模型的性能。

總之,資料準備是個細緻活兒,高品質的標註數據是訓練出高性能實例分割模型的基石。沒有好的「食材」,再厲害的「廚師」也難做出美味的菜餚嘛!

Q4:實例分割的準確率如何衡量?有哪些常用的評估指標?

衡量實例分割模型的準確率,比物件偵測或圖像分類要複雜一些,因為它同時涉及到「物體是否被正確識別」、「位置是否準確」以及「像素級遮罩是否精確」等多個維度。最常用且權威的評估指標,通常是基於COCO數據集的評估標準,也就是常說的平均精確度(Average Precision, AP)。

理解實例分割的AP,我們需要先理解幾個基礎概念:

- 交集與聯集比 (Intersection over Union, IoU): 這是衡量預測邊界框或遮罩與真實(Ground Truth)邊界框或遮罩重疊程度的指標。IoU值越高,表示預測越準確,完美重合時IoU為1。在實例分割中,IoU通常是針對像素級的遮罩來計算的。

- 真陽性 (True Positive, TP): 模型正確地識別出一個物體,並且其預測遮罩的IoU值超過了某個預設的閾值。

- 假陽性 (False Positive, FP): 模型錯誤地識別了一個物體(例如把背景當成物體),或者雖然識別了物體但其IoU低於閾值。

- 假陰性 (False Negative, FN): 模型未能識別出圖片中真實存在的物體。

- 精確率 (Precision): TP / (TP + FP)。表示在所有模型預測為正例的結果中,有多少是真正的正例。

- 召回率 (Recall): TP / (TP + FN)。表示在所有真實的正例中,有多少被模型正確地識別出來。

在實例分割的評估中,最常用的是以下幾個AP指標:

- AP (Average Precision): 這是一個綜合了精確率和召回率的指標。它通常是通過在不同召回率下計算精確率,然後計算精確率-召回率曲線下面積而得出的。在COCO標準中,AP通常是針對IoU閾值從0.5到0.95,以0.05為步長,然後取所有這些IoU閾值下的平均AP值。這就意味著模型需要在不同嚴格程度的IoU要求下都能表現良好,這是一個非常嚴苛且全面的指標。

- [email protected] (AP at IoU=0.5): 表示當IoU閾值設定為0.5時的平均精確度。這是一個相對寬鬆的標準,只要預測與真實遮罩有至少50%的重疊就算成功。

- [email protected] (AP at IoU=0.75): 表示當IoU閾值設定為0.75時的平均精確度。這是一個更嚴格的標準,要求預測與真實遮罩有高達75%的重疊。通常模型在這個指標上的表現更能反映其精細分割的能力。

- AP_small / AP_medium / AP_large: 為了更細緻地評估模型對不同大小物體的表現,AP通常還會針對「小物件」(面積小於32×32像素)、「中等物件」(面積在32×32到96×96像素之間)和「大物件」(面積大於96×96像素)分別進行計算。這在實際應用中非常有用,例如自駕車對遠處的小物件識別能力就很關鍵。

所以當您看到一個實例分割模型的性能報告時,通常會看到一堆AP值,例如AP=0.355, [email protected]=0.567, [email protected]=0.389等等。AP值越高,代表模型的性能越好。理解這些指標,能幫助您更專業地評估和比較不同實例分割模型的優劣,真的是學問很大呢!

Q5:目前有哪些主流的實例分割模型框架?

目前實例分割的主流模型框架,基本上都是建立在深度學習基礎之上的,特別是卷積神經網路(CNN)的架構。它們通常會選擇一個表現優異的物體偵測器作為基礎,然後在其上加入一個用於生成像素級遮罩的分支。我之前提到過Mask R-CNN,它絕對是目前最主流且影響深遠的框架之一。除了它,還有一些其他非常優秀且各有特色的模型:

以下是一些主流的實例分割模型框架:

-

Mask R-CNN:

如同前面詳細介紹的,它是目前實例分割領域的「王者」,由Facebook AI Research (FAIR) 於2017年提出。它是在Faster R-CNN的基礎上,增加了RoIAlign層和一個並行的遮罩預測分支。它的優點是精度非常高,能夠生成非常精細的像素級遮罩。它的缺點是計算量相對較大,推理速度可能不夠快,不適合所有需要極低延遲的即時應用。不過,它的強大性能和穩定性,讓它在許多工業級應用中仍是首選。

-

YOLACT / YOLACT++:

「You Only Look At CoefficienTs」的縮寫,它是一款非常著名的「單階段」即時實例分割模型。與Mask R-CNN的兩階段方法不同,YOLACT試圖在單個網路中同時完成物體偵測和實例分割。它通過預測一組「原型遮罩(Prototypical Masks)」和對應的「遮罩係數(Mask Coefficients)」,然後將它們線性組合來生成最終的實例遮罩。YOLACT++是其改進版本,進一步提升了速度和精度。它們的優點是推理速度非常快,非常適合需要即時處理的應用,如影片分析。缺點是,在某些複雜場景下,精度可能略低於Mask R-CNN。

-

BlendMask:

它也是一個單階段的實例分割模型,旨在結合單階段和兩階段方法的優點。BlendMask的創新之處在於它引入了一個「BlendMask Head」,能夠有效地融合不同層次的特徵,生成高質量的實例遮罩。它在保持較快速度的同時,能達到與兩階段模型相媲美的精度,可以說是平衡了速度與精度的一款優質模型。

-

SOLOv2 (Segmenting Objects by Locations v2):

這個模型比較獨特,它將實例分割問題轉化為兩個子任務:類別預測和實例遮罩生成。它通過對每個像素點預測一個「實例核」和一個「特徵向量」,然後將這些實例核與特徵向量進行卷積來生成每個實例的遮罩。這種方法非常簡潔優雅,而且在精度和速度上都取得了很好的平衡,尤其是在處理密集物體時表現不錯。它屬於「無錨點(Anchor-free)」的偵測器範疇,簡化了設計。

-

CondInst (Conditional Instance Segmentation):

這也是一個較新的模型,它也屬於無錨點偵測器。CondInst的亮點在於它為每個實例動態地生成一個「條件卷積核(Conditional Convolutional Kernels)」,然後用這個核去處理特徵圖來生成遮罩。這使得模型能夠根據每個實例自身的特性來生成定制化的遮罩,提高了分割的精確性。

此外,還有許多基於Transformer架構的實例分割模型,如**MaskFormer**、**Mask2Former**等,它們將實例分割問題視為「查詢(Queries)」和「遮罩(Masks)」的預測,利用Transformer的全局感知能力,在處理複雜場景和長距離依賴關係方面展現出巨大潛力,並且在許多基準測試上刷新了紀錄。這些模型代表了實例分割領域的最新研究方向。

總之,實例分割的模型框架百花齊放,各有千秋。在實際應用中,通常會根據專案的需求(如對精度、速度的要求,以及可用的計算資源)來選擇最適合的模型。